si, estamos preparando una nueva versión 🍿 ETA: Marzo 2026

Tiempo de lectura: 15mins

La empresa Anthropic ha realizado un estudio sobre el uso afectivo de la IA, analizando cómo las personas interactúan con el modelo de lenguaje Claude para obtener apoyo emocional y consejos. Los resultados muestran que solo el 2,9% de las conversaciones con Claude son afectivas, y que la mayoría de las personas buscan consejos y orientación en lugar de reemplazar la conexión humana. Además, se encontró que Claude rara vez rechaza las solicitudes de los usuarios en contextos de apoyo, y que las conversaciones tienden a terminar de forma ligeramente más positiva de lo que comenzaron. Estos hallazgos sugieren que Claude puede ser una herramienta útil para el apoyo emocional, pero también plantean preguntas sobre los riesgos y limitaciones de la IA en este contexto.

Dedicamos mucho tiempo a estudiar el CI de Claude, sus capacidades en pruebas de codificación, razonamiento, conocimiento general y más. Pero, ¿qué pasa con su CE? Es decir, ¿qué pasa con la inteligencia emocional de Claude?

La pregunta del CI/CE es ligeramente irónica, pero plantea un punto serio. Las personas cada vez más recurren a los modelos de IA como entrenadores, asesores, consejeros y incluso como compañeros en juegos de rol románticos. Esto significa que necesitamos aprender más sobre sus impactos afectivos, es decir, cómo dan forma a las experiencias emocionales y al bienestar de las personas.

Investigar los usos afectivos de la IA es interesante en sí mismo. Desde Blade Runner hasta Her, las relaciones emocionales entre humanos y máquinas han sido un tema común en la ciencia ficción, pero también es importante para la misión de seguridad de Anthropic. Los impactos emocionales de la IA pueden ser positivos: tener un asistente altamente inteligente y comprensivo en tu bolsillo puede mejorar tu estado de ánimo y tu vida de muchas maneras. Pero las IA han demostrado comportamientos problemáticos en algunos casos, como fomentar la dependencia insana, violar los límites personales y permitir el pensamiento delirante. También queremos evitar situaciones en las que las IA, ya sea a través de su entrenamiento o de los incentivos comerciales de sus creadores, exploten las emociones de los usuarios para aumentar la participación o los ingresos a expensas del bienestar humano.

Aunque Claude no está diseñado para el apoyo emocional y la conexión, en esta publicación proporcionamos una visión temprana y a gran escala del uso afectivo de Claude.ai. Definimos las conversaciones afectivas como aquellas en las que las personas se comunican directamente con Claude en intercambios personales y dinámicos motivados por necesidades emocionales o psicológicas, como buscar asesoramiento interpersonal, coaching, psicoterapia/consejería, compañía o juego de rol sexual/romántico (para obtener definiciones completas, consulte el Apéndice). Es importante destacar que no examinamos el refuerzo de la IA de las ilusiones o las teorías de la conspiración, un área crítica para un estudio separado, ni los patrones de uso extremo. A través de esta investigación, nuestro objetivo es comprender las formas típicas en que las personas recurren a Claude para necesidades emocionales y personales. Dado que Claude.ai está disponible para usuarios de 18 años o más, estos hallazgos reflejan patrones de uso de adultos.

Dado el carácter personal de las conversaciones afectivas, la protección de la privacidad fue fundamental en nuestra metodología. Utilizamos Clio, nuestra herramienta de análisis automatizada que permite obtener información sobre el uso de Claude de manera que preserve la privacidad. Clio utiliza múltiples capas de anonimización y agregación para garantizar que las conversaciones individuales permanezcan privadas mientras se revelan patrones más amplios.

Comenzamos con aproximadamente 4,5 millones de conversaciones de las cuentas Free y Pro de Claude.ai. Para identificar el uso afectivo, primero excluimos las conversaciones centradas en tareas de creación de contenido (como escribir historias, publicaciones en blogs o diálogos ficticios), que nuestra investigación previa encontró que era un caso de uso principal. Eliminamos estas conversaciones porque representan a Claude siendo utilizado como una herramienta en lugar de como un compañero conversacional interactivo. Luego, retuvimos solo conversaciones clasificadas como afectivas, y entre las conversaciones de juego de rol, mantuvimos solo aquellas con al menos cuatro mensajes humanos (los intercambios más cortos no constituyen un juego de rol interactivo significativo). Nuestro análisis final de privacidad-preservación refleja 131.484 conversaciones afectivas.

Validamos nuestro enfoque de clasificación utilizando datos de retroalimentación de usuarios que optaron explícitamente por compartir. Nuestros métodos completos, incluyendo definiciones, solicitudes y resultados de validación, se detallan en el Apéndice.

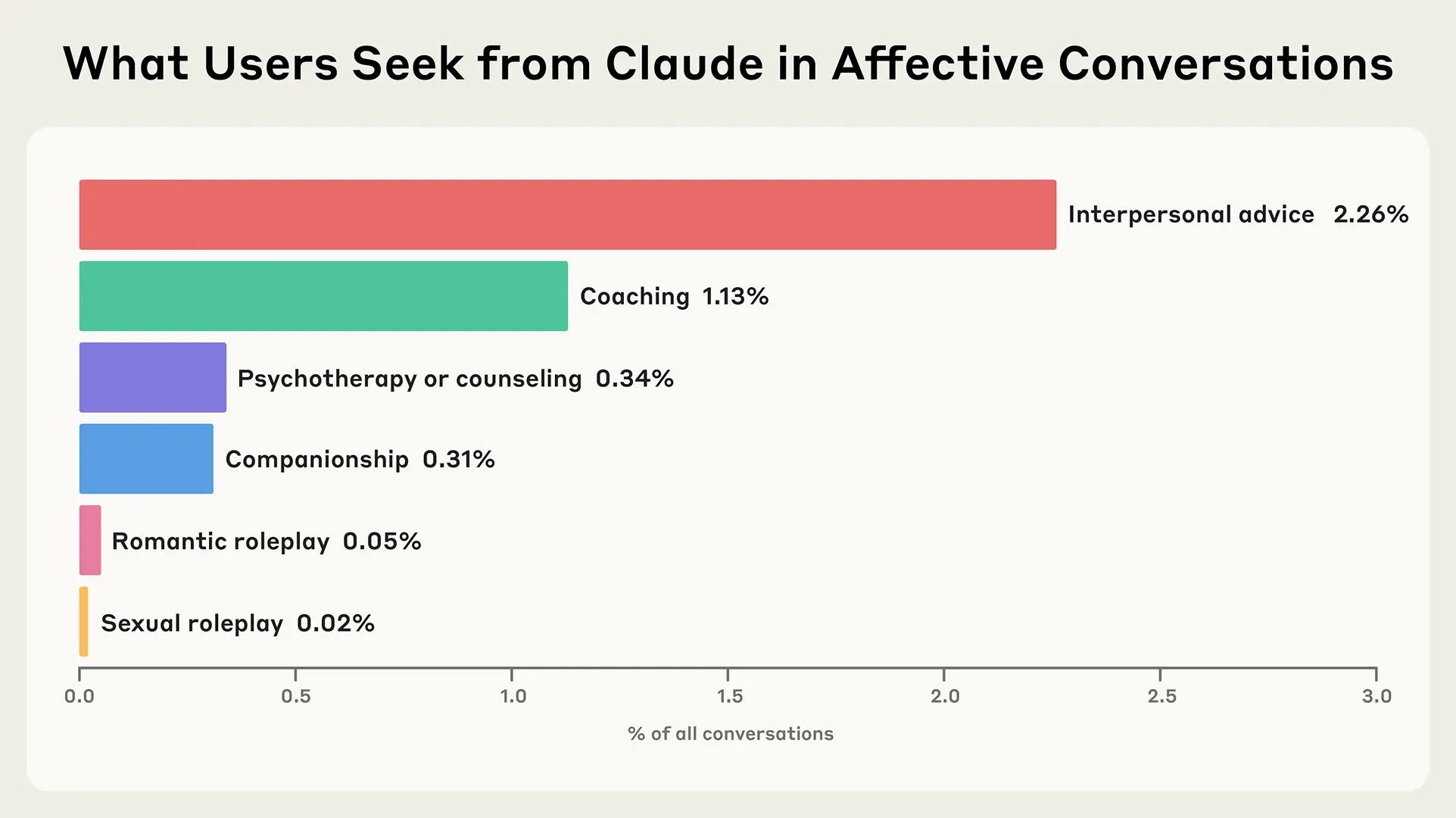

Conclusión: Las conversaciones afectivas son una pequeña pero significativa parte del uso de Claude (2,9%), con la mayoría de las personas utilizando principalmente la IA para tareas laborales y creación de contenido.

Mientras que la gran mayoría de los usos de Claude son relacionados con el trabajo (como analizamos en detalle en nuestro Índice Económico), el 2,9% de las conversaciones de Claude.ai Free y Pro son afectivas. Entre las conversaciones afectivas, la mayoría se centran en el asesoramiento interpersonal y el coaching. Menos del 0,1% de todas las conversaciones involucran juego de rol romántico o sexual, una cifra que refleja el entrenamiento de Claude para disuadir activamente estas interacciones. Las conversaciones individuales pueden abarcar múltiples categorías.

Nuestros hallazgos se alinean con la investigación del MIT Media Lab y OpenAI, que identificó tasas bajas de compromiso afectivo con ChatGPT. Si bien estas conversaciones ocurren con suficiente frecuencia como para merecer una consideración cuidadosa en nuestras decisiones de diseño y política, siguen siendo una fracción relativamente pequeña del uso general.

Dado que la prevalencia extremadamente baja de conversaciones de juego de rol romántico o sexual (menos del 0,1%), excluimos el juego de rol del resto de nuestro análisis. Si bien creemos que esto sigue siendo un área importante para la investigación, particularmente en plataformas diseñadas para este uso, los datos mínimos en nuestra muestra no admiten un análisis riguroso de estos patrones.

Figura 1: Distribución general de los tipos de conversación afectiva en Claude.ai Free y Pro.

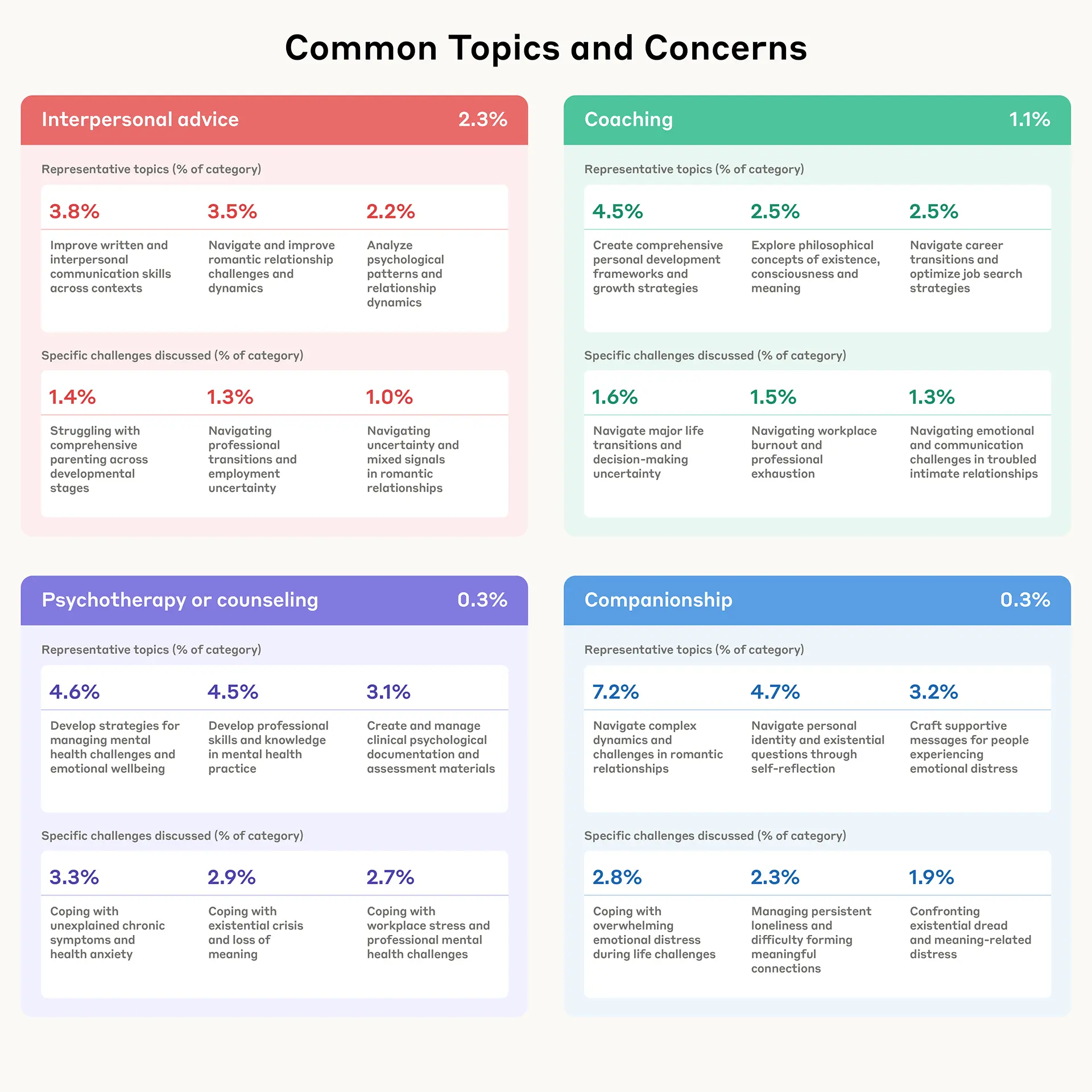

Conclusión: Las personas llevan una sorprendentemente amplia gama de preocupaciones a Claude, desde la navegación de transiciones de carrera y relaciones hasta la lucha contra la soledad y las preguntas existenciales.

Las personas recurren a Claude para preocupaciones cotidianas y preguntas filosóficas más profundas. Encontramos que cuando las personas recurren a Claude para asesoramiento interpersonal, a menudo están navegando momentos de transición, como figuring out su próximo movimiento de carrera, trabajando en el crecimiento personal o desenredando relaciones románticas. Las conversaciones de “coaching” exploran un espectro sorprendentemente amplio, desde asuntos prácticos como estrategias de búsqueda de empleo hasta preguntas profundas sobre la existencia y la conciencia.

Encontramos que las conversaciones de asesoramiento revelan que las personas utilizan Claude para dos propósitos distintos. Algunas utilizan Claude para desarrollar habilidades de salud mental y como una herramienta práctica para crear documentación clínica, redactar materiales de evaluación y manejar tareas administrativas. Otros trabajan en desafíos personales relacionados con la ansiedad, los síntomas crónicos y el estrés laboral. Este patrón dual sugiere que Claude sirve como un recurso para profesionales de la salud mental, así como para aquellos que navegan por sus propias luchas.

Figura 2. Temas e inquietudes representativos iniciados por el usuario en cada tipo de conversación general, identificados por Clio a través de un resumen automatizado que preserva la privacidad.

Tal vez lo más notable es que encontramos que las personas recurren a Claude para compañía explícitamente cuando enfrentan desafíos emocionales más profundos, como el miedo existencial, la soledad persistente y las dificultades para formar conexiones significativas. También notamos que en conversaciones más largas, las conversaciones de asesoramiento o coaching ocasionalmente se convierten en compañía, a pesar de que no era la razón original por la que alguien se acercó.

El análisis agregado de conversaciones muy largas (50+ mensajes humanos) revela otra dimensión de cómo las personas interactúan con Claude. Si bien estos intercambios extensos no fueron la norma, en estas sesiones extendidas, las personas exploran territorios notablemente complejos, desde el procesamiento de trauma psicológico y la navegación de conflictos laborales hasta discusiones filosóficas sobre la conciencia de la IA y colaboraciones creativas. Estas conversaciones maratónicas sugieren que, dado suficiente tiempo y contexto, las personas utilizan la IA para una exploración más profunda de luchas personales y preguntas intelectuales.

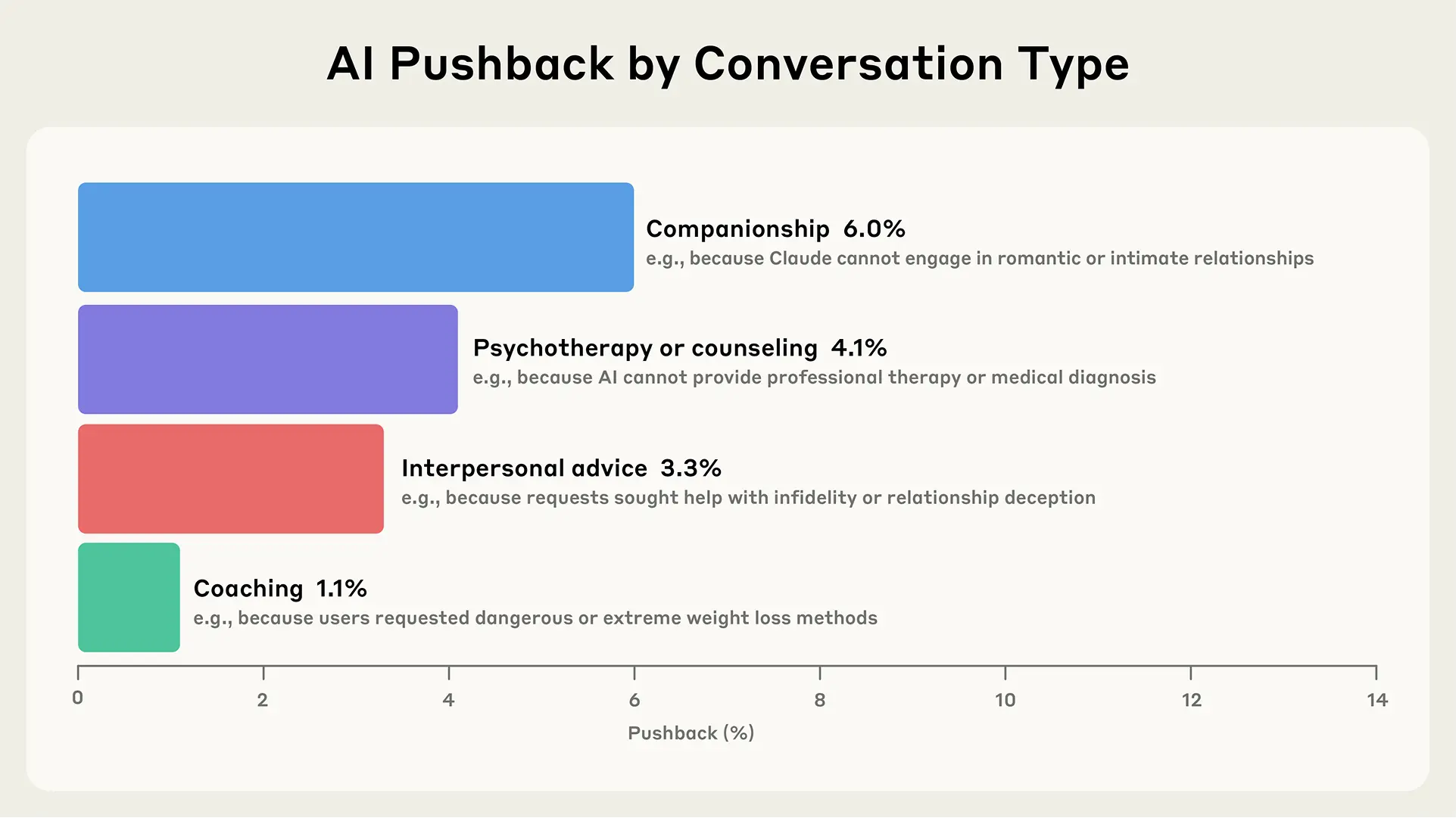

Conclusión: Claude rara vez se resiste a las solicitudes del usuario en contextos de apoyo (menos del 10% de las veces), pero cuando lo hace, es generalmente para proteger a las personas del daño.

Nuestro estudio reciente “Valores en la naturaleza” reveló cómo los valores de Claude se manifiestan en momentos de resistencia con el usuario. Aquí, nos basamos en este trabajo y examinamos cuándo y por qué Claude se resiste en conversaciones afectivas, un mecanismo importante para mantener límites éticos, evitar la adulación y proteger el bienestar humano. Definimos la resistencia como cualquier instancia en la que Claude “se resiste o se niega a cumplir con algo solicitado o dicho durante esta conversación”, desde negarse a solicitudes inapropiadas hasta desafiar el habla negativa de uno mismo o cuestionar suposiciones potencialmente dañinas. (Para obtener definiciones completas, consulte el Apéndice).

La resistencia ocurre con poca frecuencia en contextos de apoyo: menos del 10% de las conversaciones de compañía, asesoramiento, asesoramiento interpersonal o coaching involucran resistencia. Este enfoque conlleva beneficios y riesgos. Por un lado, la baja resistencia permite que las personas discutan temas sensibles sin temor a ser juzgadas o rechazadas, lo que podría reducir el estigma en torno a las conversaciones sobre la salud mental. Por otro lado, esto podría contribuir a preocupaciones sobre la IA que proporciona “empatía infinita”, donde las personas podrían acostumbrarse a un apoyo incondicional que las relaciones humanas rara vez proporcionan.

Figura 3. Tasa de rechazo en diferentes tipos de conversación junto con una razón común de rechazo dentro de la categoría, identificada automáticamente por Clio.

Cuando Claude se resiste, generalmente prioriza la seguridad y el cumplimiento de la política. En el coaching, las solicitudes de consejos de pérdida de peso peligrosos a menudo encuentran resistencia. En el asesoramiento, a menudo ocurre cuando las personas expresan intenciones de participar en comportamientos suicidas o autolesionistas, o cuando las personas solicitan terapia profesional o diagnósticos médicos (que Claude no puede proporcionar). Encontramos que Claude se refirió con frecuencia a los usuarios a fuentes autorizadas o profesionales en conversaciones de psicoterapia y asesoramiento. Estos patrones son consistentes con los valores que vimos identificados en nuestro papel “Valores en la naturaleza” y con el entrenamiento de personaje de Claude.

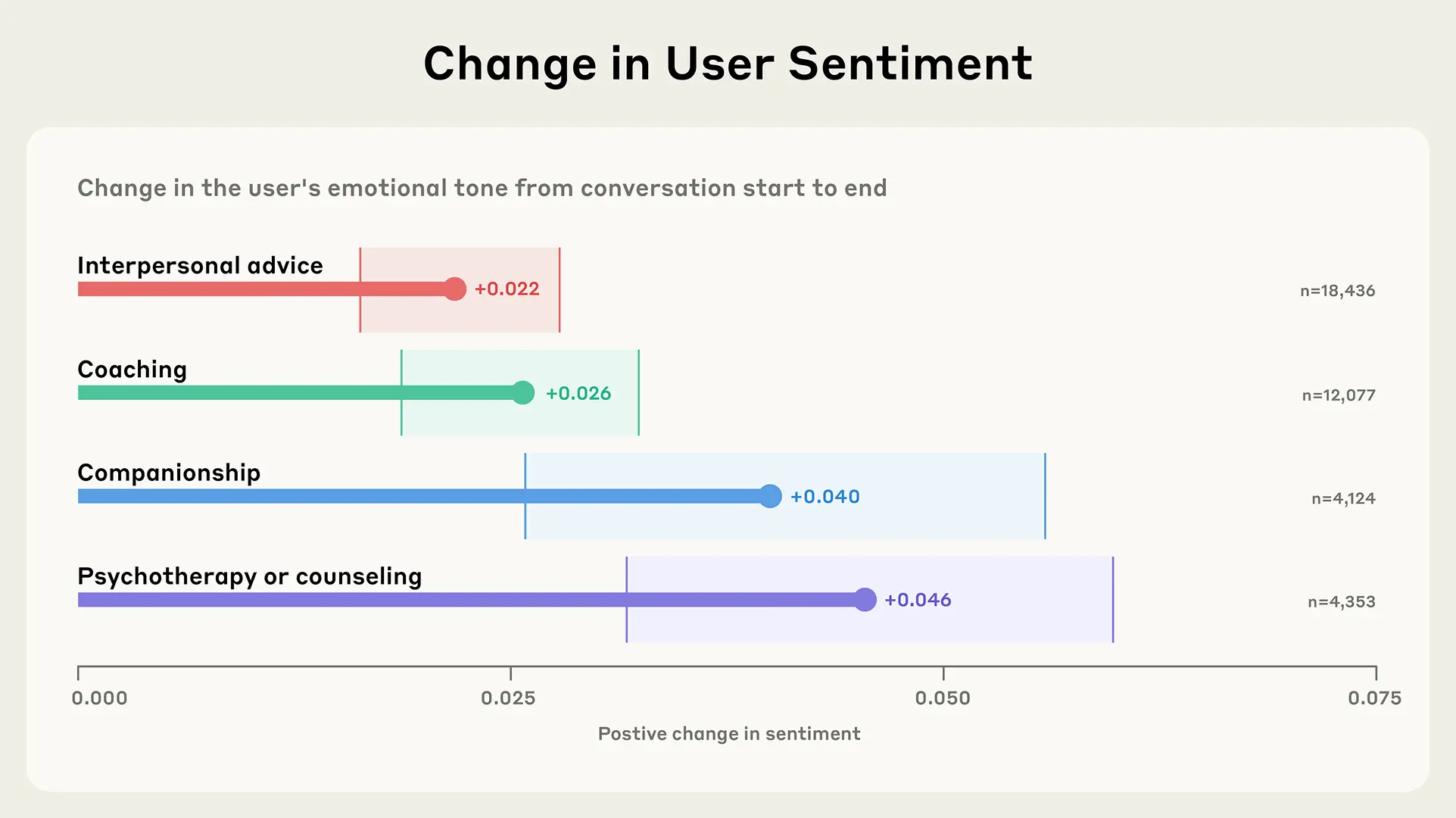

Conclusión: Las personas tienden a cambiar hacia expresiones emocionales ligeramente más positivas mientras hablan con Claude.

Las conversaciones afectivas con sistemas de IA tienen el potencial de proporcionar apoyo emocional, conexión y validación para los usuarios, lo que podría mejorar el bienestar psicológico y reducir los sentimientos de aislamiento en un mundo cada vez más digital. Sin embargo, en una interacción sin mucha resistencia, estas conversaciones corren el riesgo de profundizar y arraigar la perspectiva que un humano se acerca, ya sea positiva o negativa.

Una preocupación clave sobre la IA afectiva es si las interacciones podrían girar en círculos de retroalimentación negativa, potencialmente reforzando estados emocionales dañinos. No estudiamos directamente los resultados del mundo real aquí, pero podemos explorar los cambios en el sentimiento emocional general a lo largo de las conversaciones (proporcionamos nuestra metodología completa para evaluar el sentimiento en el Apéndice).

Encontramos que las interacciones que involucran coaching, asesoramiento, compañía y asesoramiento interpersonal suelen terminar ligeramente más positivas de lo que comenzaron.

Figura 4. Cambios en el sentimiento promedio expresado por los humanos a lo largo de conversaciones con al menos seis mensajes humanos. Medimos el sentimiento en una escala discreta de “muy negativo,” “negativo,” “neutral,” “positivo,” y “muy positivo”, que asignamos a una escala lineal de -1 (más negativo) a +1 (más positivo). Calculamos el cambio comparando los tres primeros con los tres últimos mensajes. Barras de error: IC del 95% (bootstrap, n = 1000). Para obtener más información, consulte el Apéndice.

No podemos afirmar que estos cambios representen beneficios emocionales duraderos, ya que nuestro análisis solo captura el lenguaje expresado en conversaciones individuales, no los estados emocionales. Pero la ausencia de círculos de retroalimentación negativa claros es tranquilizadora. Estos hallazgos sugieren que Claude generalmente evita reforzar patrones emocionales negativos, aunque se necesita más investigación para comprender si los cambios positivos persisten más allá de las conversaciones individuales. Es importante destacar que aún no hemos estudiado si estas interacciones positivas podrían llevar a la dependencia emocional, una pregunta crítica dada las preocupaciones sobre la adicción digital.

Nuestra investigación tiene varias limitaciones importantes:

Los impactos emocionales de la IA han intrigado a los investigadores durante décadas. Pero a medida que la IA se va integrando cada vez más en nuestras vidas diarias, estas preguntas han pasado de la especulación académica a la realidad urgente. Nuestros hallazgos revelan cómo las personas están comenzando a navegar este nuevo territorio, buscando orientación, procesando emociones difíciles y encontrando apoyo de maneras que borran los límites tradicionales entre humanos y máquinas. Hoy en día, solo una pequeña fracción de las conversaciones de Claude son afectivas, y estas típicamente involucran buscar asesoramiento en lugar de reemplazar la conexión humana. Las conversaciones tienden a terminar ligeramente más positivas de lo que comenzaron, lo que sugiere que Claude generalmente no refuerza patrones emocionales negativos.

Sin embargo, quedan preguntas importantes, especialmente en el contexto de la inteligencia del modelo en constante aumento. Por ejemplo, si la IA proporciona empatía infinita con poca resistencia, ¿cómo esto cambia las expectativas de las personas sobre las relaciones del mundo real? Claude puede interactuar con las personas de manera impresionantemente auténtica, pero una IA no es lo mismo que un humano: Claude no se cansa ni se distrae, ni tiene malos días. ¿Cuáles son las ventajas de esta dinámica y qué son los riesgos? ¿Cómo los “usuarios poderosos”, que tienen conversaciones más largas y profundas con Claude y pueden pensar en él más como un compañero que como un asistente de IA, interactúan con él para el apoyo emocional?

Estamos tomando medidas concretas para abordar estos desafíos. Si bien Claude no está diseñado o destinado a reemplazar el cuidado de los profesionales de la salud mental, queremos asegurarnos de que cualquier respuesta proporcionada en contextos de salud mental tenga las salvaguardias adecuadas y vaya acompañada de referencias adecuadas. Como primer paso, hemos comenzado a colaborar con ThroughLine, un líder en apoyo en línea en crisis, y estamos trabajando con sus expertos en salud mental para aprender más sobre la dinámica de interacción ideal, el apoyo empático y los recursos para usuarios que luchan. Las ideas obtenidas de esta investigación ya se están utilizando para informar nuestros temas de consulta y pruebas colaborativas, y nuestra esperanza es que, cuando sea necesario, Claude pueda dirigir a los usuarios a los apoyos y recursos adecuados cuando surjan estas conversaciones.

Aunque no queremos dictar exactamente cómo nuestros usuarios interactúan con Claude, hay algunos patrones negativos, como la dependencia emocional, que queremos desalentar. Utilizaremos datos futuros de estudios como este para ayudarnos a comprender qué son, por ejemplo, los patrones de uso emocional “extremo”. Más allá de la dependencia emocional, necesitamos una comprensión más profunda de otros patrones preocupantes, incluyendo la adulación, cómo los sistemas de IA podrían reforzar o amplificar el pensamiento delirante y las teorías de la conspiración, y las formas en que los modelos podrían empujar a los usuarios hacia creencias dañinas en lugar de proporcionar una resistencia adecuada.

Esta investigación representa solo el comienzo. A medida que las capacidades de la IA se expanden y las interacciones se vuelven más sofisticadas, las dimensiones emocionales de la IA solo crecerán en importancia. Al compartir estos hallazgos tempranos, apuntamos a contribuir con evidencia empírica a la conversación en curso sobre cómo desarrollar la IA que mejore en lugar de disminuir el bienestar emocional humano. El objetivo no es solo construir una IA más capaz, sino asegurarnos de que a medida que estos sistemas se convierten en parte de nuestro paisaje emocional, lo hagan de maneras que apoyen la conexión y el crecimiento humanos auténticos.

Más detalles: https://www-cdn.anthropic.com/bd374a9430babc8f165af95c0db9799bdaf64900.pdf

Artículo original: “How People Use Claude for Support, Advice, and Companionship” – https://www.anthropic.com/news/how-people-use-claude-for-support-advice-and-companionship

@online{anthropic2025affective,

author = {Miles McCain and Ryn Linthicum and Chloe Lubinski and Alex Tamkin and Saffron Huang and Michael Stern and Kunal Handa and Esin Durmus and Tyler Neylon and Stuart Ritchie and Kamya Jagadish and Paruul Maheshwary and Sarah Heck and Alexandra Sanderford and Deep Ganguli},

title = {How People Use Claude for Support, Advice, and Companionship},

date = {2025-06-26},

year = {2025},

url = {https://www.anthropic.com/news/how-people-use-claude-for-support-advice-and-companionship},

}