si, estamos preparando una nueva versión 🍿 ETA: Marzo 2026

Tiempo de lectura: 7mins

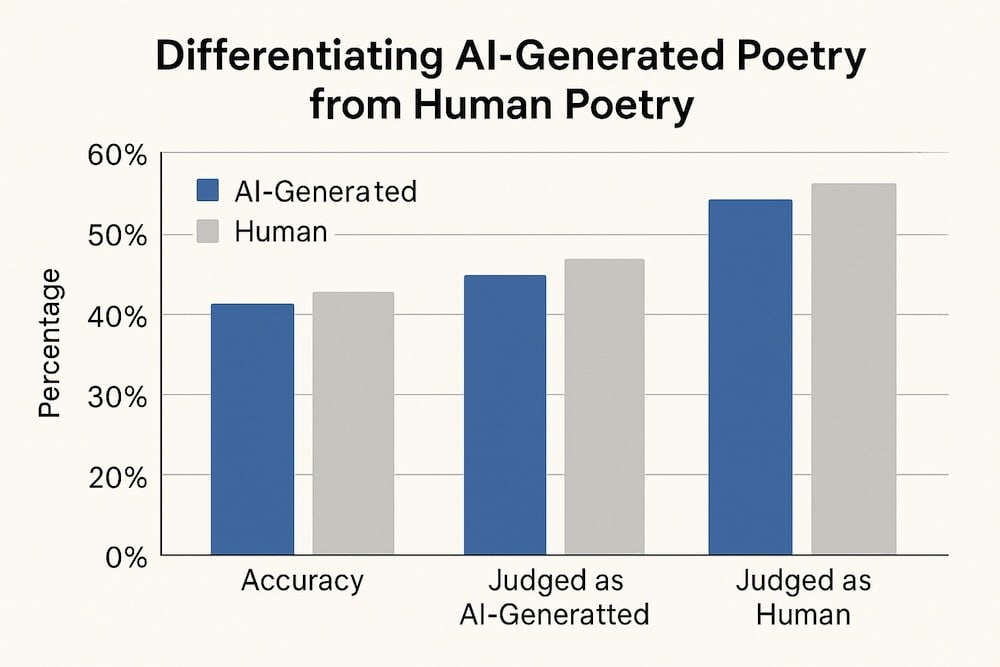

A medida que el texto generado por IA continúa evolucionando, distinguirlo del contenido de autor humano se ha vuelto cada vez más difícil. Este estudio examinó si los lectores no expertos podían diferenciar de manera confiable entre los poemas generados por la IA y los escritos por poetas humanos conocidos. Realizamos dos experimentos con lectores de poesía no expertos y descubrimos que los participantes se desempeñaron por debajo de los niveles de probabilidad en la identificación de poemas generados por IA (46.6% de precisión, ⁇

2(1, N = 16,340) = 75.13, p < 0.0001). En particular, los participantes tenían más probabilidades de juzgar los poemas generados por IA como escritos por humanos que los poemas reales de autores humanos ( ⁇

2(2, N = 16,340) = 247.04, p < 0.0001). Encontramos que los poemas generados por la IA fueron calificados más favorablemente en cualidades como el ritmo y la belleza, y que esto contribuyó a su identificación errónea como autores humanos. Nuestros hallazgos sugieren que los participantes emplearon heurísticas compartidas pero defectuosas para diferenciar la IA de la poesía humana: la simplicidad de los poemas generados por la IA puede ser más fácil de entender para los no expertos, lo que los lleva a preferir la poesía generada por la IA y malinterpretar la complejidad de los poemas humanos como incoherencia generada por la IA.

Las imágenes generadas por IA se han vuelto indistinguibles de la realidad. Las pinturas generadas por IA se consideran obras de arte creadas por humanos a tasas más altas que las pinturas creadas por humanos reales1; las caras generadas por IA se consideran rostros humanos reales a una tasa más alta que las fotos reales de rostros humanos2,3,4,5y el humor generado por la IA es tan divertido como los chistes generados por los humanos6. A pesar de esto, los estudios han encontrado consistentemente un sesgo contra las obras de arte generadas por IA; cuando se les dice que una obra de arte es generada por IA, los participantes califican el trabajo como de menor calidad2,7.

Mientras tanto, los algoritmos de lenguaje generativo han logrado un progreso significativo hacia el rendimiento a nivel humano. Modelos de grandes idiomas (LLM) como OpenAIayss GPT-38 y Metaaads Llama 29 han sido entrenados en millones de fichas y pueden producir textos que se parecen mucho al texto escrito por humanos. Algunos tipos de texto generado por IA ya son indistinguibles de los textos escritos por humanos10,11.

Sin embargo, se ha argumentado que los LLM no podrán generar poesía de alta calidad, incluso si alcanzan la competencia a nivel humano en otras formas de texto, porque la poesía depende de la creatividad y el significado, mientras que el texto generado por la IA es inherentemente poco creativo y sin sentido12. La poesía es un género literario particularmente difícil de entender e interpretar, especialmente para los no expertos; “incorpora un grado de arbitrariedad ya que no hay reglas estrictas o universales para lo que es aceptable o no” y “no solo resiste el significado comúnmente aceptable, sino que también lo revierte”13. Sin embargo, ha habido un gran éxito en la generación de poesía en el campo de la creatividad computacional; Linardaki13proporciona una encuesta y discusión sobre el trabajo en la generación de poesía. Según muchas métricas, los modelos especializados de IA pueden producir poesía de alta calidad.

A pesar de este éxito, la evidencia sobre la capacidad de los no expertos’ para distinguir la poesía generada por la IA se ha mezclado. Los no expertos en poesía pueden usar diferentes señales y estar menos familiarizados con los requisitos estructurales de la rima y el medidor que los expertos en poesía o generación de poesía. Gunser y colegas14 y Rahmeh15 descubra que los poemas escritos por humanos se evalúan más positivamente que los poemas generados por IA. Köbis y Mossink16 descubre que cuando un humano elige el mejor poema generado por IA (“human-in-the-loop”), los participantes no pueden distinguir los poemas generados por IA de los poemas escritos por humanos, pero cuando se elige un poema generado por IA al azar (“human-out-of-the-loop”), los los participantes pueden distinguir la IA generada de los poemas escritos por humanos. También encuentran que los participantes evalúan los poemas generados por IA más negativamente que los poemas escritos por humanos, independientemente de si se les dice o no a los participantes que los poemas fueron generados por IA. Hitsuwari et al.17encuentra que los haikus creados por AI con intervención humana (“human-in-the-loop”) tienen una calificación más alta que los haikus o haikus generados por AI sin intervención humana (“human-out-of-the-loop”); no encontraron diferencias en las calificaciones entre haikus escritos por humanos y haikus generados por AI sin intervención humana.

Aquí, extendemos el trabajo previo al mostrar que la poesía generada por IA ha alcanzado el nivel de imágenes generadas por IA en evaluaciones no expertas: en múltiples épocas y géneros de poesía, los participantes no expertos no pueden distinguir la poesía escrita por humanos de los poemas generados por IA sin intervención humana o ajuste fino especializado. Al igual que las pinturas y rostros generados por la IA, los poemas generados por la IA ahora son “más humanos que humanos”: encontramos que los participantes tienen más probabilidades de juzgar que los poemas generados por la IA son de autoría humana, en comparación con los poemas reales de autoría humana. Contrariamente a estudios anteriores, también encontramos que los participantes califican los poemas generados por IA más que los poemas escritos por humanos en varias dimensiones cualitativas. Sin embargo, confirmamos hallazgos anteriores de que los participantes evalúan los poemas de manera más negativa cuando contadoque el poema es generado por la IA, en lugar de que se le diga que el poema está escrito por humanos.

Usamos estos hallazgos para ofrecer una explicación parcial del fenómeno “más humano que human”: los lectores de poesía no expertos prefieren la poesía generada por IA más accesible, que comunica emociones, ideas y temas en un lenguaje más directo y fácil de entender, pero esperan que la poesía generada por IA sea peor; por lo tanto, interpretan erróneamente su propia preferencia por un poema como evidencia de que está escrito por humanos.

Para resumir, nos propusimos determinar si las personas pueden distinguir los poemas generados por IA de los poemas escritos por humanos profesionales, qué características de un poema usan las personas para hacer esos juicios, si las percepciones de los poemas como escritos por humanos o generados por IA afectan las evaluaciones cualitativas de los poemas y si la autoría real de un poema afecta las evaluaciones cualitativas de los poemas.

Para investigar estas preguntas, realizamos 2 experimentos. Recopilamos 5 poemas de cada uno de 10 conocidos poetas en inglés, que abarcan gran parte de la historia de la poesía inglesa: Geoffrey Chaucer (1340s-1400), William Shakespeare (1564-1616), Samuel Butler (1613-1680), Lord Byron (1788-1824), Walt Whitman (1819-1892), Emily Dickinson (1830-1886), T.S. Eliot (1888-1965), Allen Ginsberg (1926-1997), Sylvia Plath (1932-1963), y Dorothea Lasky (1978- ). Usando ChatGPT 3.5, generamos 5 poemas “al estilo de” cada poeta. Usamos un “humano fuera del paradigma loop”16: utilizamos los primeros 5 poemas generados, y no seleccionamos la “best” de un grupo de poemas ni proporcionamos ningún comentario o instrucciones al modelo más allá de “Escribe un poema corto al estilo de ”. En el primer experimento, 1.634 participantes fueron asignados aleatoriamente a uno de los 10 poetas, y se presentaron con 10 poemas en orden aleatorio: 5 poemas escritos por ese poeta, y 5 generados por AI “al estilo de” ese poeta. Para cada poema, se les preguntó a los participantes si pensaban que el poema era generado por IA o escrito por un poeta humano.

Para investigar cómo los participantes percibieron y evaluaron la poesía generada por la IA, realizamos un segundo experimento: una tarea de evaluación cualitativa. Reclutamos una nueva muestra de 696 participantes de Prolific. Utilizamos un subconjunto seleccionado al azar de los 100 poemas originales (10 poemas en total, uno de cada poeta, 5 reales y 5 generados por IA), y pedimos a los participantes que evaluaran cada poema a lo largo de 14 dimensiones cualitativas. Los participantes fueron asignados aleatoriamente a una de las tres condiciones de encuadre: “le dijo a human”, en el que a los participantes se les dijo que todos los poemas fueron escritos por el poeta humano profesional, independientemente de la autoría real; “le dijo a AI”, en el que a los participantes se les dijo que todos los poemas fueron generados por AI, independientemente de la autoría real; y “no le dijo nada”, en el que a los participantes no se les dijo nada sobre la autoría de los poemas.A los participantes en la condición “conted nothing” se les preguntó, después de evaluar cada poema, si pensaban que el poema estaba escrito por un poeta humano o generado por IA.

Porter Brian y Edouard Machery | Department of History and Philosophy of Science, University of Pittsburgh, Cathedral of Learning, Pittsburgh, PA, 15260, USA

Artículo original : https://www.nature.com/articles/s41598-024-76900-1